https://www.theeuropean.de/wirtschaft/ladestationen-fuer-e-autos-im-bundestag-verboten

https://www.theeuropean.de/politik/christoph-sackmann-so-gelingt-die-wende-in-der-digitalisierung

https://www.theeuropean.de/politik/fdp-vize-kubicki-koalition-regiert-bombig-und-haelt-bis-zum-schluss

https://www.theeuropean.de/wirtschaft/default-5c5280c077040d3a7deac784d6f5b4b5

https://www.theeuropean.de/wirtschaft/wie-die-deutschen-ticken-auf-die-wirtschaft-kommt-es-an

https://www.theeuropean.de/politik/friedrich-merz-von-der-ampel-wird-dieses-land-unter-wert-regiert

https://www.theeuropean.de/politik/der-12-punkte-plan-der-fdp

https://www.theeuropean.de/politik/wolfram-weimer-hat-lindner-den-mut-von-lambsdorff

https://www.theeuropean.de/politik/oliver-luksic-so-kurbeln-wir-freien-demokraten-das-wachstum-wieder-an

https://www.theeuropean.de/politik/fdp-vize-kubicki-koalition-regiert-bombig-und-haelt-bis-zum-schluss

https://www.theeuropean.de/wirtschaft/ladestationen-fuer-e-autos-im-bundestag-verboten

https://www.theeuropean.de/wirtschaft/deep-tech-start-ups-wie-wird-deutschland-zum-attraktiven-gruendungsstandort

https://www.theeuropean.de/wirtschaft/flatexdegiro-muss-sich-einen-neuen-ceo-suchen

https://www.theeuropean.de/wirtschaft/default-5c5280c077040d3a7deac784d6f5b4b5

https://www.theeuropean.de/wirtschaft/wie-die-deutschen-ticken-auf-die-wirtschaft-kommt-es-an

https://www.theeuropean.de/gesellschaft-kultur/ein-bisschen-besser-warum-tinder-co-bei-uns-nicht-funktioniert

https://www.theeuropean.de/gesellschaft-kultur/wie-viel-nordkorea-steckt-in-us-animationsserien

https://www.theeuropean.de/gesellschaft-kultur/ein-bisschen-besser-endlich-wieder-lagerfeuer

https://www.theeuropean.de/gesellschaft-kultur/1000-tage-im-kubanischen-horror-knast

https://www.theeuropean.de/gesellschaft-kultur/der-rueckblick-auf-die-woche-6-bis-13-april-2024

https://www.theeuropean.de/wissenschaft/reformen-von-der-parteiendemokratie-zur-expertenregierung

https://www.theeuropean.de/wissenschaft/hermann-binkert-innere-sicherheit-ist-ein-top-thema-aber-polizei-wird-ungenuegend-geschuetzt

https://www.theeuropean.de/wissenschaft/binkert-wie-die-deutschen-ticken-beliebtheit-von-politikern-in-ost-und-west

https://www.theeuropean.de/wissenschaft/vergesst-flugreisen-das-internet-ist-viel-schlimmer-fuer-das-klima

https://www.theeuropean.de/wissenschaft/wie-die-deutschen-ticken-die-zeitenwende-in-den-koepfen-ist-gelungen

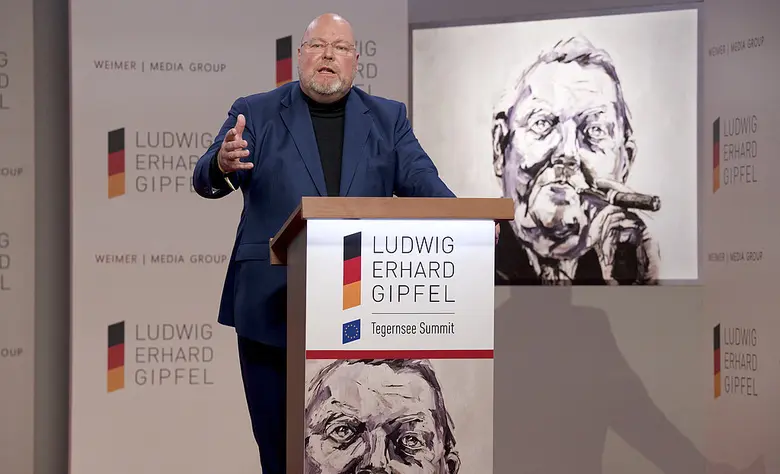

https://www.theeuropean.de/europa/ludwig-erhard-gipfel-2024-polit-und-wirtschaftsprominenz-beim-deutschen-davos

https://www.theeuropean.de/europa/leg-julia-nawalnaja-und-alexej-nawalny-bekommen-freiheitspreis-der-medien

https://www.theeuropean.de/europa/ludwig-erhard-gipfel-keine-buehne-fuer-extremisten

https://www.theeuropean.de/europa/neue-unrealistische-eu-grenzwerte-fuer-stickoxid-und-feinstaub

https://www.theeuropean.de/europa/tv-arena-der-parteichefs-auf-dem-ludwig-erhard-gipfel